Tubes à vide

Les tubes à vide comme les triodes étaient les composants essentiels des premiers ordinateurs dans les années 1940.

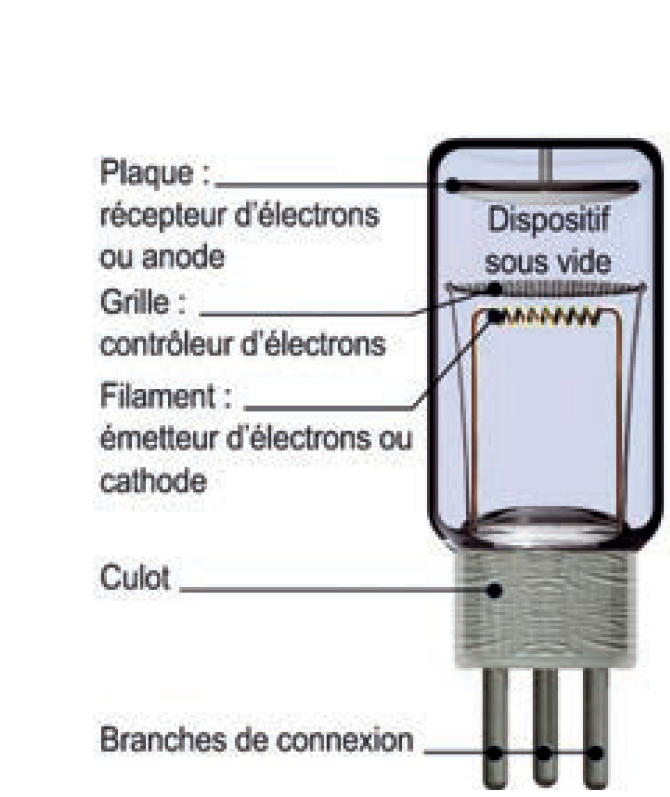

C'est quoi un tube à vide ?

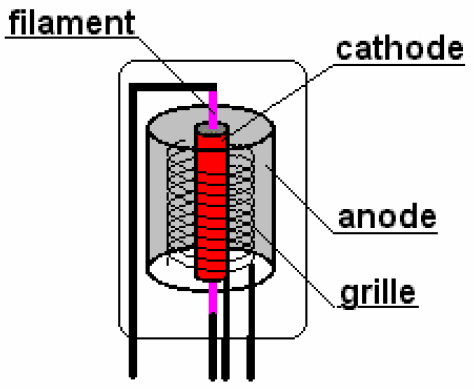

Un tube à vide est un dispositif électronique qui permet de contrôler le flux d'électrons dans le vide entre une cathode et une anode. Une tension est appliquée pour permettre ou bloquer le passage du courant, amplifiant ainsi les signaux.

La triode (grâce à une grille de contrôle) permet de moduler le flux d’électrons.

Cependant, ces premiers ordinateurs, tels que l'ENIAC (Electronic Numerical Integrator and Computer), utilisaient des milliers de tubes à vide pour effectuer des calculs électroniques. Chaque tube à vide était capable d'amplifier ou de commuter un signal électronique, mais ils avaient de nombreux défauts :

-

Les tubes à vide étaient très volumineux.

Par exemple, l'ENIAC contenait environ 17 500 tubes à vide et occupait une salle entière. - Ces tubes chauffaient énormément, nécessitant un refroidissement constant. La chaleur excessive affectait la performance et la durée de vie des composants.

- Les tubes à vide étaient fragiles et avaient tendance à claquer fréquemment, nécessitant des remplacements réguliers.

- Les tubes à vide consommaient beaucoup d'énergie pour fonctionner, rendant les systèmes coûteux à entretenir et inefficaces sur le plan énergétique.

Ce manque de fiabilité, ainsi que la taille et la consommation énergétique des tubes, freinaient considérablement le développement de l'informatique.

Des circuits discrets aux circuits intégrés

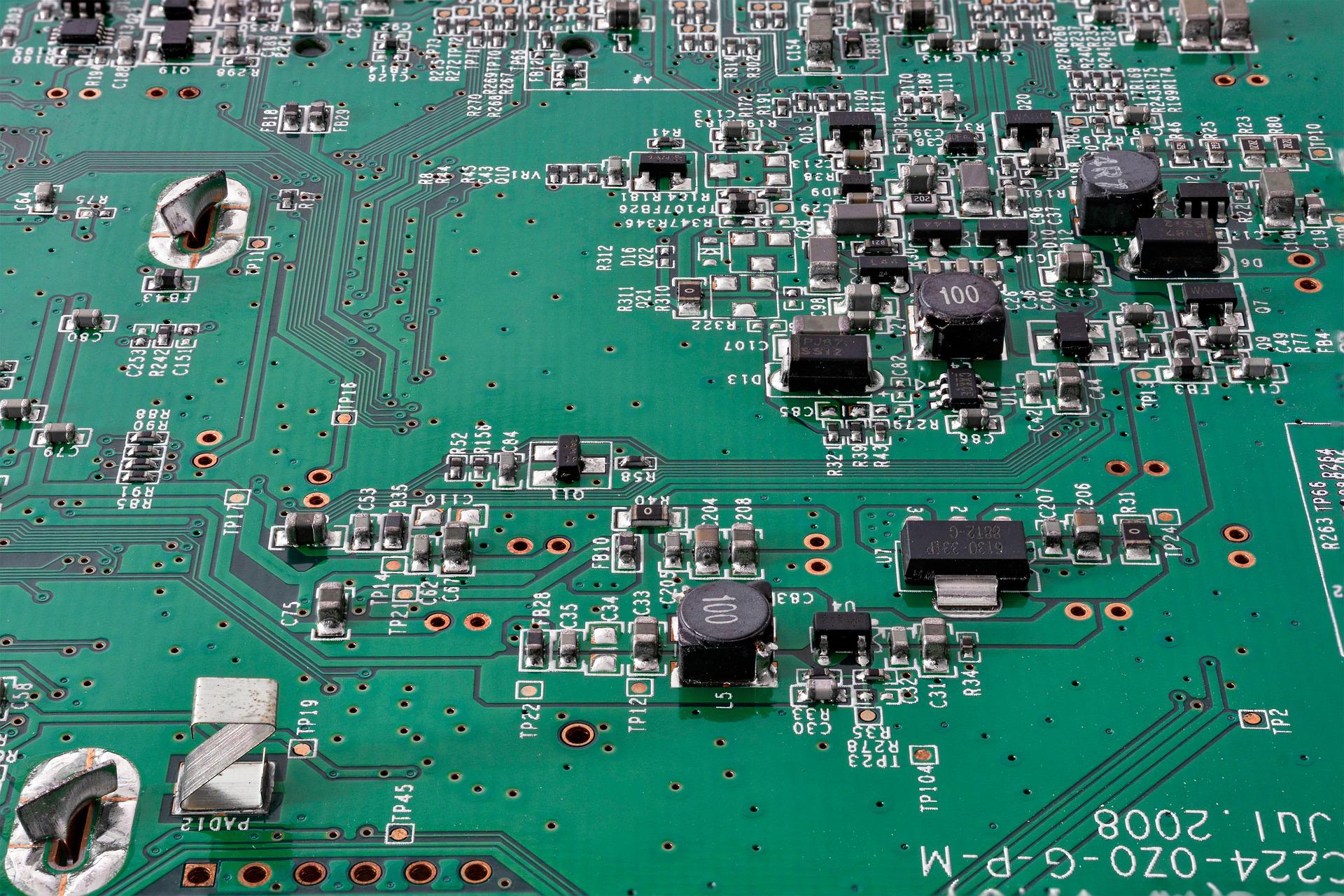

Un circuit électrique est un assemblage simple ou complexe de composants électriques ou électroniques reliés par des fils conducteurs. Alors qu'un circuit imprimé (comme la carte mère d'un ordinateur) est une plaque utilisée pour connecter et supporter des composants électroniques entre eux. Il est composé d'un matériau isolant sur lequel sont imprimées des pistes conductrices en cuivre. Ces pistes remplacent les fils utilisés dans les circuits traditionnels et permettent de relier les différents composants (résistances, condensateurs, transistors, etc.) de manière ordonnée et efficace.

Les premiers ordinateurs utilisant des transistors ont vu le jour dans les années 1950 et 1960, notamment au Massachusetts Institute of Technology (MIT).

Cependant, les circuits étaient encore discrets : les transistors et les autres composants (résistances, condensateurs...) étaient montés séparément sur des circuits imprimés.

L'émergence du microprocesseur (circuit intégré)

Bien que plus fiable et plus compacts que les systèmes à tubes à vide, les circuits discrets à transistors étaient encore encombrants, complexes à assembler et fragiles à grande échelle.

Le premier brevet de circuit intégré est déposé en février 1959 par l'Américain Jack Kilby de Texas Instruments, devançant de peu l'Américain Robert Noyce de l'entreprise Fairchild Semiconductor qui menait des recherches dans la même direction. C’est chez Fairchild, en revanche, que réside la solution pour fabriquer ces circuits intégrés en très grande quantité.

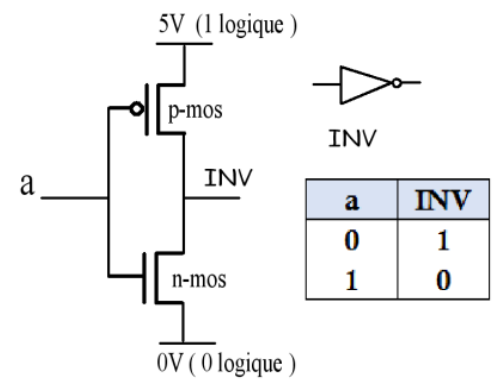

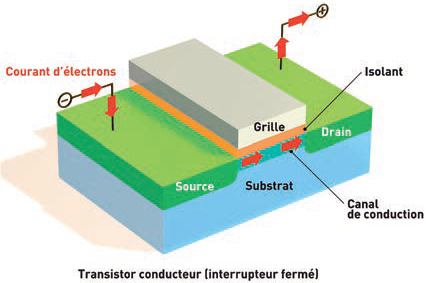

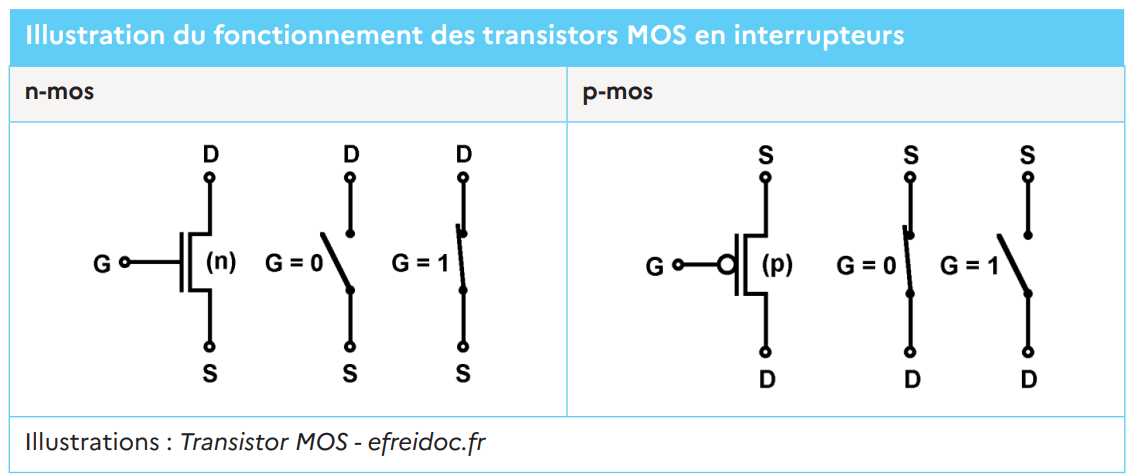

Le transistor est le composant de base qui permet de contrôler le flux d'électricité dans un circuit.

En combinant plusieurs transistors, il est possible de créer des portes logiques, qui sont les unités fondamentales de tout calcul électronique.

Les portes logiques, comme les portes ET, OU, et NON, réalisent des opérations booléennes simples sur des bits (0 ou 1), formant ainsi les éléments constitutifs des circuits numériques.

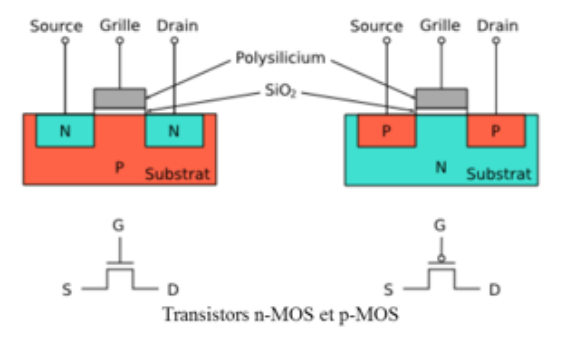

Aujourd'hui, le transistor MOS (Metal Oxide Semiconductor) constitue, grâce à sa simplicité de fabrication et à ses dimensions réduites, l'élément fondamental des circuits intégrés numériques.

Les circuits intégrés ont permis de compacter des milliers de transistors sur une seule puce de silicium, rendant possible des systèmes beaucoup plus petits et plus puissants. Cela a conduit, au développement des premiers microprocesseurs et ordinateurs personnels, marquant une avancée significative dans l'informatique.

Les circuits intégrés ont permis de compacter des milliers de transistors sur une seule puce de silicium, rendant possible des systèmes beaucoup plus petits et plus puissants. Cela a conduit, au développement des premiers microprocesseurs et ordinateurs personnels, marquant une avancée significative dans l'informatique.

Les circuits intégrés sont désormais présents dans tous les appareils électroniques modernes, des smartphones aux voitures, en passant par les satellites.

L'ère de la miniaturisation

La loi de Moore

La réduction de la taille des transistors permet de réduire la distance parcourue par les signaux électriques tout en limitant la consommation d'énergie et la chaleur.

Gordon Moore, co-fondateur d'Intel, a prédit, en 1965, que le nombre de transistors sur une puce doublerait environ tous les deux ans.

On l'a, en effet, observé : une augmentation continue des performances des processeurs et une réduction simultanée de leur taille et de leur consommation d'énergie.

Par exemple, alors que le premier microprocesseur, l'Intel 4004, contenait environ 2 300 transistors, les processeurs modernes en contiennent plusieurs milliards.

Quant à la fréquence d'horloge (vitesse de calcul) des processeurs, elle était de 740 kHz pour l'Intel 4004. Les processeurs d'aujourd'hui ont une fréquence d'horloge moyenne comprise entre 1,5 GHz et 6 GHz. Ce qui rend possibles des tâches complexes comme l'intelligence artificielle, la simulation scientifique, et l'informatique quantique.

Cependant, cette loi est remise en question en raison des limites physiques et économiques auxquelles sont confrontées les technologies actuelles de fabrication de puces.

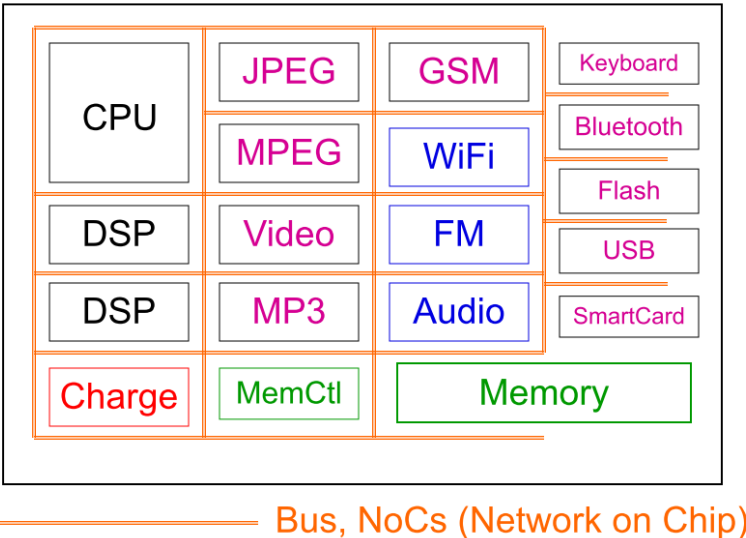

Vers une intégration plus poussée : System on Chip (SoC)

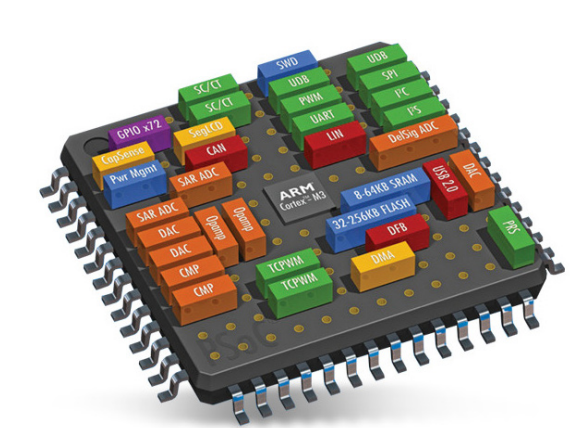

Contrairement aux premiers ordinateurs à circuits intégrés qui reposaient sur des CPU distincts, un SoC intègre non seulement le processeur (CPU), mais également plusieurs autres composants essentiels comme la mémoire, le processeur graphique (GPU), les interfaces réseau et les modules de gestion de l'énergie sur une seule puce.

Un SoC regroupe ainsi toutes les fonctions nécessaires à un système informatique complet dans un seul composant miniaturisé, ce qui permet une meilleure efficacité énergétique et une réduction des coûts de fabrication.

Cette miniaturisation permet non seulement de rendre les dispositifs plus petits et plus légers, mais aussi de réduire leur consommation énergétique, ce qui est essentiel pour les appareils portables comme les smartphones et les ordinateurs portables.

De plus, cette intégration poussée permet de traiter plus rapidement des volumes massifs d’informations, facilitant ainsi les progrès dans des domaines comme la 5G, l’intelligence artificielle, et le cloud computing.

Les unités de traitement graphique (GPU), qui ont initialement été développées pour accélérer le rendu des images en 3D dans les jeux vidéo, sont désormais largement utilisées dans les systèmes d’IA pour traiter de grandes quantités de données en parallèle.

Par ailleurs, les puces spécialisées pour l'IA, comme celles développées par Nvidia ou Google (TPU - Tensor Processing Unit), permettent d'accélérer l'entraînement des modèles d'IA et de déployer ces technologies dans des applications du quotidien, comme la reconnaissance vocale ou la conduite autonome.

Du design à la fabrication

De par ses propriétés de semi-conducteur, le matériau de base des circuits intégrés est aujourd'hui encore le silicium (extrait du sable : oxyde de silicium).

La fabrication collective de puces électroniques, qui fait chuter les coûts unitaires, est l’un des atouts majeurs de l’industrie microélectronique. Mais elle durcit aussi les exigences de production : une erreur de manipulation, quelques secondes en plus ou en moins et ce sont plusieurs centaines de circuits qui finissent à la poubelle…

De plus, elle mobilise d'énormes ressources financières ; c'est pourquoi, le nombre de fabricants de puces électroniques est trop réduit à l'échelle planétaire.

Les 6 étapes clés de la fabrication de puces

-

Le traitement thermique

Réalisé dans des fours à des températures de 800 à 1 200° C, il permet de réaliser des couches d'oxyde et de nitrure de silicium par exemple, réarranger des réseaux cristallins ou effectuer certains dopages. -

Les dépôts

Ils apportent à la surface du silicium des couches conductrices ou isolantes. -

La photolithographie

Étape-clé, elle consiste à reproduire dans la résine photosensible le dessin des circuits à réaliser. Ces motifs complexes sont générés en une seule exposition. La lumière d’une source lumineuse de très faible longueur d’onde (UV ou rayons X, pour les gravures les plus fines) y projette l’image d’un masque. Plus la résolution optique est poussée, plus la miniaturisation des circuits est améliorée. -

Le nettoyage

Les nombreuses opérations de nettoyage des tranches représentent presque un tiers du temps total de processus de fabrication. -

La gravure

A l’inverse du dépôt, la gravure enlève de la matière, toujours dans le but de réaliser un motif. Deux voies principales : la gravure dite humide, qui utilise des réactifs liquides, et la gravure sèche (ou gravure plasma) qui emploie des réactifs gazeux. En 2004, les gravures les plus fines en production mesuraient 130 nm. Dix ans après, elles n’étaient plus que de 14 nm ! -

Le dopage

Pour introduire au cœur du silicium les atomes qui vont modifier sa conductivité, les plaquettes sont chauffées entre 800 et 1 100° C dans des fours, en présence du gaz dopant, ou bombardées par implantation à travers un masque par un faisceau d’ions accélérés.

Pour finaliser la fabrication, une pellicule métallique est déposée aux endroits où le circuit devra être en contact avec les broches de sortie. Puis les circuits intégrés sont testés, directement sur le wafer. Enfin, celui-ci est découpé pour obtenir des puces, insérées dans un boîtier individuel de protection et reliées aux broches qui vont leur permettre de communiquer avec l'extérieur. Des tests de validation et de qualification, à différentes fréquences et températures, sont alors entrepris.